28.3.10

Transfer-Folie(n)

Bin gerade darüber gestolpert und total fasziniert: So stellen also zahllose Tätowierer ihre Vorlagen her. Es gibt spezielle Thermofax-Geräte, es geht aber auch mit einem stinknormalen Faxgerät. Naja ganz normal vielleicht nicht. Es muss noch mit Thermopapier abeiten. Und eine Kopierfunktion besitzen. Hab meines gerade weggeworfen #*§$%&! Egal. Dann nimmt man ein Blatt Papier und legt ein Blatt Blaupause, Kohlepapier, Durchpauspapier (oder wie immer man das nennt) darauf. Das ganze kommt in den Papiereinzug. Nun die zu kopierende Zeichnung (spiegelverkehrt!) einlegen und den Prozess starten.

Diese Kopie übertragen Tätowierer nun zB mit etwas Seife oder Ultraschallgel (sieht man zB in diesem Video) auf die Haut. Fertig ist das "Nichtpermanente" Tatoo für einen Sommerabend!

Vielleicht könnte man so auch ein Letraset ("Rubbelbuchstaben") herstellen? Andererseits gibt es ja schon DecalPro fx von Pulsar. Geniale Transferfolie, mit der ein "dry transfer" auf nahezu alle Materialien (!) möglich ist. Von der gleichen Firma: "Fab-In-A-Box", das auf ähnliche Weise die doch recht knifflige Belichtung von Platinenlayouts überflüssig macht. Ausdrucken, transferieren, ätzen, fertig! Eine Bezugsquelle mit weiteren Infos ist der Druckeronkel.

Siebdruck

Eine sehr schöne Anleitung: Siebdruck/Textildruck für Schwachmaten (Original leider inzwischen nicht mehr verfügbar. Aber zum Glück gibts Archive.orgs Wayback Machine!) Theoretisch reichen Mückennetz und Holzrahmen aus dem Baumarkt plus Photopolymer (siehe dieses Posting) und eine beliebige Farbe, um in die Siebdruckproduktion einzusteigen. Aber je besser das Material, desto besser das Produkt. Also sollte man beim Netz (Sieb) auf die richtige Fadenzahl achten (Fertigprodukte haben zB 28 Fäden pro cm in Kettrichtung und 30 in Schussrichtung) und auch beim Bau des Rahmens sorgfältig arbeiten.

Alternativen zum selbst aufgetragenen Photopolymer wären: Thermofax (eine fertige Folie, die auf Wärme reagiert, kann man zB hier kaufen) oder EZScreenPrint (lichtsensitiv, aber bereits fertig beschichtet, wie die UV-Platten zur Platinenherstellung). Bei Youtube gibt’s selbstverständlich eine Anleitung.

Nicht zu Verwechseln ist das Photopolymer übrigens mit der Photoemulsion: Mit ihr können Fotos auf (fast) beliebige Oberflächen belichtet werden. Es ist im Grunde die gleiche Chemikalie, die auch auf herkömmlichen Fotosabzügen (nicht Digitaldruck, versteht sich) benutzt wird, nur in flüssiger Form. Was man damit alles anstellen kann, erfahrt ihr auf der Seite von www.alternativephotography.com.

23.3.10

Stempelherstellung

Endlich gefunden: Eine schöne Anleitung*, wie man Stempel selbst herstellt. Natürlich nicht durch Schnitzen von Radiergummis oder so nem Gedöns, sondern durch das Belichten eines Photopolymers (z.B. von Trodat oder Colop). Der Vorgang ähnelt dem Ätzen von Platinen oder Chips, bloß ohne Ätzen! UV-Licht reicht, sogar das eines sonnigen Tages. Gleichzeitig können sehr komplexe Motive realisiert werden. Es gibt auch fertige UV-Stempelplatten, z.B. bei cc-products. Diese Variante wird in diesem PDF erklärt (hier noch eine andere Version). Im industriellen Maßstab wird dieses Verfahren übrigens als Flexodruck bezeichnet.

UPDATE: Leider hat Torsten Kruckenberg* seine Anleitung aus dem Netz genommen. Immerhin wurde im Internet-Archiv der Text abgespeichert…

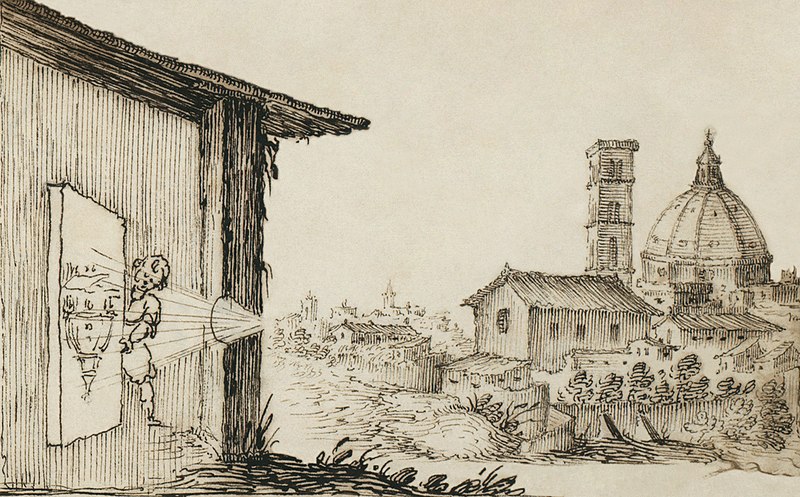

Camera obscura + lucida

Dachte, ich hätte das schon gepostet, habe ich aber noch nicht. Also dann: Der Vorläufer der Kamera, die "Camera obscura", wurde bereits im 4. Jahrhundert v. Chr. erwähnt - vom einem Philospophen. Aristoteles beschrieb in der "Problemata physica" erstmals die Enstehung eines auf dem Kopf stehenden Bildes, wenn Licht durch ein kleines Loch in einen dunklen Raum fällt. Der Künstler David Hockney vermutet in seinem Buch Secret Knowledge: Rediscovering the Lost Techniques of the Old Masters, dass Künstler wie Ingre, Van Eyck und Caravaggio nicht freihändig arbeiteten, sondern dass die Bilder, die durch einen ungewöhnlich hohen Detailreichtum und Realismus überraschen, mit Hilfe solcher optischen Hilfen entstanden. Es gibt aber viele Künstler, die das ganz anders sehen.

Wie auch immer: 1807 patentierte Wiliam Hyde Wollaston dann die "Camera lucida", bei der man durch ein Guckloch die Umrisse eines Motivs direkt auf das Zeichenpapier projeziert bekommt. Allerdings hatte Johannes Kepler dieses Gerät bereits 1611 in seiner "Dioptrice" beschrieben. Besser gut geklaut als schlecht selbst erfunden, sozusagen. Der Anwender kann dadurch gleichzeitig die Umrisse des Motivs und das Papier sehen und das Objekt einfach abzeichnen. Im Grunde ist das eine frühe Form der Augmentet Reality. Nun musste nur noch das projezierte Bild fixiert werden - fertig ist die Fotokamera (= Pinhole Camera). Doch zunächst entwickelte sich die "Camera lucida" im Laufe des 19. und 20. Jahrhunderts zu einem wichtigen Hilfsmittel in der Entomologie zum genauen Zeichnen des Flügelgeäders von Insekten. BTW: Camera obscura = Lateinisch "Dunkle Kammer". Camera Lucida = "Helle Kammer".

Auch heutzutage findet die Camera obscura noch Anwendung: Zum Beispiel im "Altonaer Museum" (Hamburg), wo ein Live-Bild an der Elbe mit einer großen Camera obscura aufgenommen und in den Eingangsbereich des Museums projeziert wird. Dieser Wikipedia-Eintrag enthält einige andere begehbare Exemplare. Und der Fotograf Abelardo Morell verdunkelt einfach Hotelzimmer u.ä. um sie so in Lochkameras zu verwandeln:

So etwas können wir vom Team ZEUK auch. Tipp: Um auch große Fensterflächen komplett Lichtdicht zu bekommen, bietet sich Alufolie an. Einfach etwas Wasser (evnt. mit etwas Spülmittel) auf die Glasfläche auftragen und die Folie direkt von der Rolle auflegen und mit einem feuchten Schwamm andrücken bzw. Luftblasen herauswischen. Funzt viel besser als Pappe oder Sperrholz, wo meist irgendwo doch etwas Licht durchschimmert. Mal abgesehen von der viel einfacheren Montage und der Tatsache, dass die Projektion umso besser wird, je dünner das Material ist, in dem sich die Öffnung befindet!

14.3.10

CryEngine 3

Fünf Videos von der 10. "Game Developer Conference": Crytek stellt die neue CryEngine vor. In diesem Posting erwähnte ich die alte "Sandbox" und die offiziellen Anleitungen zur Bedienung und Programmierung. Doch die CryEngine 3 setzt da wohl noch einen drauf, obwohl nach oben ja gar nicht mehr so viel Platz ist (solange keine Quanten-PCs existieren). Die neue Engine ist z.B. etwas effizienter, läuft auch auf Konsolen und das in Echtzeit! Änderungen im Editor werden also zeitgleich auf der (Entwickler-)Konsole visualisiert. Und statt sich um Dutzende von Parametern kümmern zu müssen, hat man beispielsweise nur einen Schieberegler, um mal schnell die Tageszeit (und somit die Belichtungsverhältnisse) anzupassen.

13.3.10

CUDA, SLI + PhysX

Nachdem ich Arkham Asylum nun schon nahezu durchgespielt habe, entdecke ich sowas! Das Spiel sah ohnehin dufte aus, aber mit der PhysX-Erweiterung kommen wirklich noch ein paar sehr leckere Effekte dazu. Da nicht jeder weiß (und ich auch erst seit kurzem) wie das alles funktioniert - hier eine Schnellbesohlung:

Die PhysX-Chips wurden von der US-Firma Ageia entwickelt und ermöglichten die erste und bisher einzige "Physikbeschleuniger"-Karte (PPU). Sie entlastet die CPU bei Simulationen und war damals eine Ergänzung der Grafikkarte (GPU), kein Ersatz. Statt maximal 200 simulierten Objekten sollen durch das Zusammenspiel von CPU, GPU und PPU bis zu 64.000 Festkörper berechnet werden können. 2008 kaufte Nvidia die Firma und sicherte sich diese immer wichtiger werdende Technologie. ATI-Karten können seither NICHT mehr mit PhysX arbeiten. Leider.

PhysX gibt es als eigenständige Karte (selten), doch vor allem ist es Bestandteil der aktuellen Nvidia-GPUs. Hat man zwei Nvidia-Grafikkarten per SLI ("Scalable Link Interface) zusammengeschaltet, gibt es zwei Möglichkeiten: Im "SLI"-Modus berechnen beide Karten neben den Bildern auch die Physik. Nvidia empfiehlt jedoch bei PhysX-Spielen den "Multi-GPU"-Modus zu aktivieren: Hier kümmert sich eine Grafikkarte um das Rendern der Grafik, während die andere ausschließlich für die Physik zuständig ist.

Die zweite Grafikkarte kann einer älteren Generation angehören, muss jedoch CUDA-fähig sein. CUDA ist die "Compute Unified Device Architecture", eine von Nvidia entwickelte Technik zur Beschleunigung wissenschaftlicher und technischer Berechnungen durch Einbeziehung der Grafikkarte. Die Technologie kommt zum Beispiel auch bei Netbooks mit ION-Chip zum Einsatz: Der entlastet die schmalbrüstigen Atom-CPUs bei grafisch anspruchsvollen Aufgaben, wurde bisher aber von Flash-Videos (YouTube & Co) ausgebremst, da diese keine Grafikprozessoren nutzen, sondern nur von einer schnellen CPU profitieren. Der Flashplayer 10.1 nutzt nun jedoch die CUDA-Schnittstelle, die Videos werden also von CPU + GPU verarbeitet und laufen so auch auf entsprechenden Netbooks flüssig.

Zusammenfassung:

- CPU + integrierter Grafikchip = 2D. Das war schon bei C64, Amiga & Co so.

- Dann kam das 3D-Zeitalter, ein simpler Grafikchip war damit überfordert. Grafikkarten (GPUs) übernehmen seither die Berechnungen.

- Besonders schwere Fälle wie "Crysis" knacken zwei oder drei GPUs, per SLI zusammengeschaltet.

- Wenn man schon GPU(s) hat, kann man die ja auch für wichtigeres als Spiele nutzen: CUDA bringt GPU(s) dazu, sich auch um 2D zu kümmern. Quasi.

- Nach simplem 3D ist nun physikalisch korrektes 3D angesagt, was PhysX auf den Plan rief. Also Hardware, die CPU + GPU von diesen Berechnungen entlastet.

2.3.10

DIY Blade Runner

Da werden Träume... naja, nicht wirklich wahr. Aber in mir entsteht beim Anblick solcher Bilder das Bedürfnis nach einer richtig zeitgemäßen Spielumsetzung von "Blade Runner". Das Bild ist nur eines von vielen, die Ilya Nedyal, Steven Chagon und Alina Gal mit Hilfe der Crysis-Engine für einen "Game Artist" Wettbewerb verwirklicht haben. Nach Aussage der Künstler sind das hier Screenshots, also KEINE in Photoshop aufgemotzten Bilder! Unglaublich. Das beste: Die "SandBox 2" steht jedermann kostenlos zur Verfügung und ist Bestandteil jeder Crysis-DVD. Erste Schritte erleichtern die SandBox Tutorials bei YouTube, die volle Packung an Infos stellt der Hersteller zur Verfügung. Einige "Blade Runner"-Modelle hat SciFi 3D schon fix-und-fertig im Angebot. Alles andere modellieren wir mit 3DS max (leider nicht mit Silo, Milkshape (gratis), Wings3D (gratis) oder Hexagon 2, denn für die gibts keine Exporter-PlugIns). Um bei Blade Runner noch mal Maß zu nehmen, gibt es hier die Perle als FullHD-Download... :)

Abonnieren

Posts (Atom)